28-2. Generative Models 2

1. Latent Variable Models

[ D. Kingma, "Variational Inference and Deep Learning: A New Synthesis," Ph. D. Thesis ]

Autoencoder는 생성모델인가? 사실 그렇지 않다.

2. Variational Auto-encoder

Variational Inference (VI)

The goal of VI is to optimize the variational distribution that best matches the posterior distribution.

- Posterior distribution: q_(\phi)(z|x)

In particular, we want to find the variational distribution that minimizes the KL divergence between the true posterior.

문제는 posterior가 뭔지 모르는 데 posterior distribution을 구해야 한다.

Importantly, ELBO is a tractable quantity.

ELBO can further be decomposed into

결국은 Z라는 것을 찾고 싶은 것이다.

Key limitation:

- It is an intractable model (hard to evaluate likelihood).

- The prior fitting term must be differentiable, hence it is hard to use diverse latent prior distributions.

- In most cases, we use an isotropic Gaussian.

3. Adversarial Auto-encoder

It allows us to use any arbitrary latent distributions that we can sample.

4. Generative Adversarial Network (GAN)

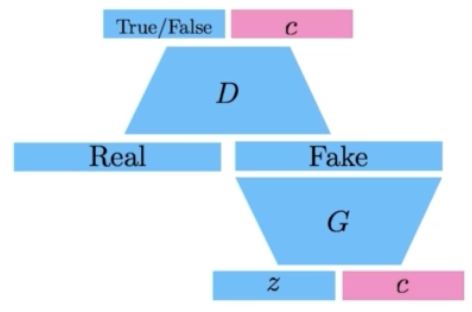

5. GAN v.s VAE

GAN은 True가 나오도록 D를 계속 학습한다.

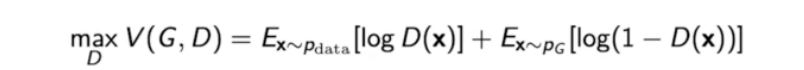

6. GAN Objective

A two-player minimax game between generator and discriminator.

For discriminator:

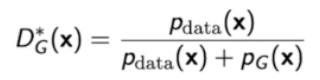

where the optimal discriminator is

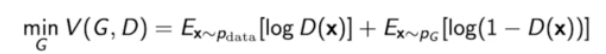

For generator:

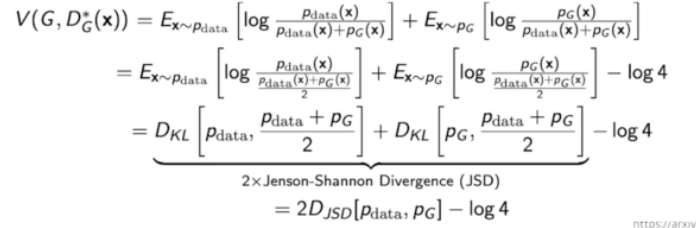

Plugging in the optimal discriminator, we get

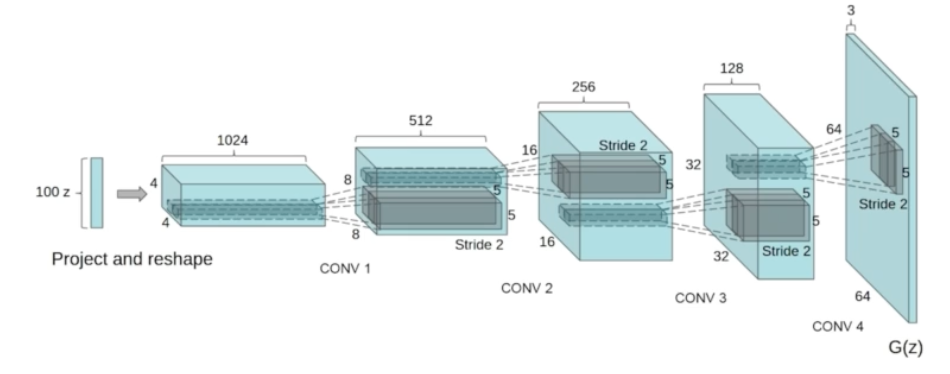

7. DCGAN

Image Domain을 사용했다.

8. Info-GAN

GAN이 특정 모드에 집중할 수 있도록 한다.

9. Text2Image

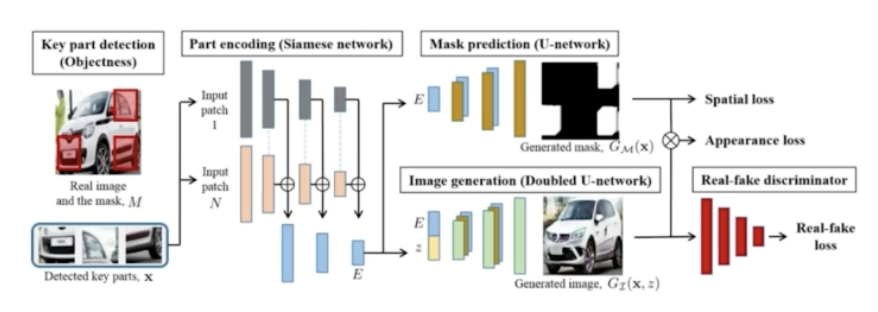

10. Puzzle-GAN

이미지 안에 sub-patch가 있다.

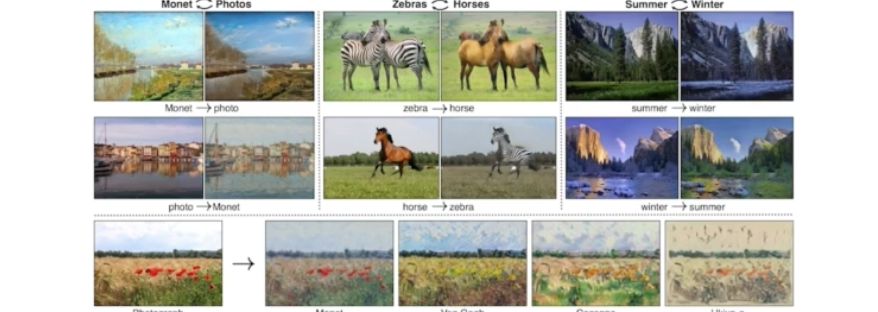

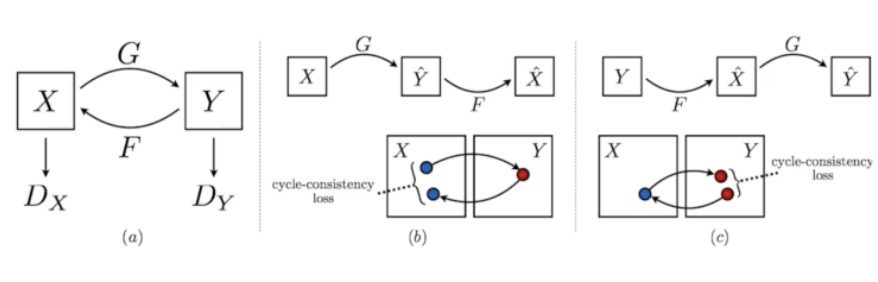

11. CycleGAN

사진의 Domain을 바꿀 수 있다.

장점: 두 다른 domain 사이에서, 객체만 바꿔주도록 한다.

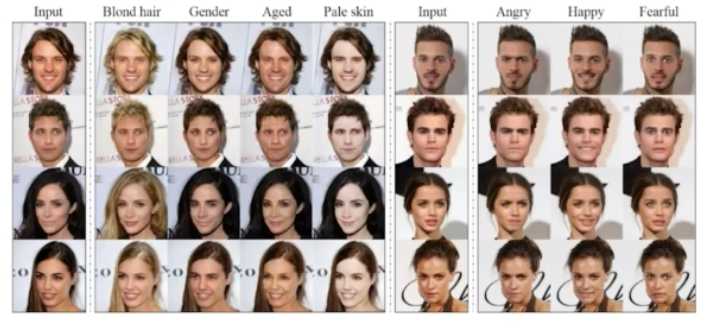

12. Star-GAN

11과 같지만, 이미지를 컨트롤할 수 있도록 해준다.

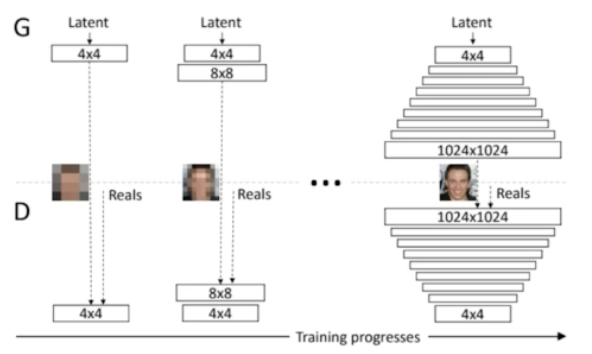

13. Progressive-GAN

고차원의 이미지 GAN이다.

저→고로 올라가며 train을 한다.

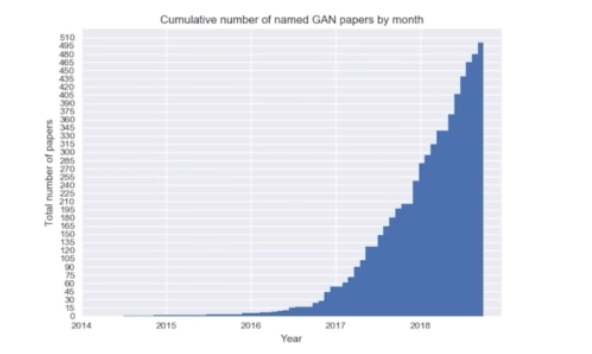

and WAY MORE

©️NAVER Connect Foundation. All Rights Reserved.

'취업준비 > 인공지능' 카테고리의 다른 글

| [AI Tech] 6주차 28-4차시 Quiz 12 (0) | 2024.02.23 |

|---|---|

| [AI Tech] 6주차 28-3차시 클로바 스튜디오 연습 (0) | 2024.02.23 |

| [AI Tech] 6주차 28-1차시 Generative Models 1 (0) | 2024.02.23 |

| [AI Tech] 6주차 27-4차시 Quiz 11 (0) | 2024.02.23 |

| [AI Tech] 6주차 27-3차시 RNN 연습 (0) | 2024.02.23 |