20-2. Historical Review

Deep Learning's Most Important Ideas - A Brief Historical Review

- Denny Britz 2020-07-29

2012

AlexNet

CNN이고 224*224 이미지 파일을 분류하는 대회에서 우승했다.

약간의 패러다임 변화가 일어난 것이다. (기존에는 고전적인 모델들을 사용했다.)

2013

DQN

방법론 자체는 Q-learning에 딥러닝을 접목한 방법이다.

2014

Encoder / Decoder

이 방법은 NMT(Neural Machine Translation) 문제를 풀기 위해 개발되었다.

다른 언어로 되어 있는 문장을 우리가 번역하고 싶은 언어로 자연스럽게 변화시켜 주는 것

영어 단어의 sequence를 만들어주는 모델이다.

기계어 번역의 근간이다.

Adam Optimizer

Adam을 그냥 쓰는 경우가 많은데, 이것은 Adam의 결과가 좋기 때문이다.

일반적으로 Deep Learning Model을 만들 때 파라미터를 정하게 되고, 잘 설정해야 성능이 좋아진다.

2015

Generative Adversarial Network(GAN)

네트워크가 Generator와 Discriminator 2개를 만들어 학습시키는 것이다.

"술 마시는게 연구에 도움이 된다."

Residual Networks

우리가 현재 부르는 딥러닝이라고 불리게 된 계기이다.

2017

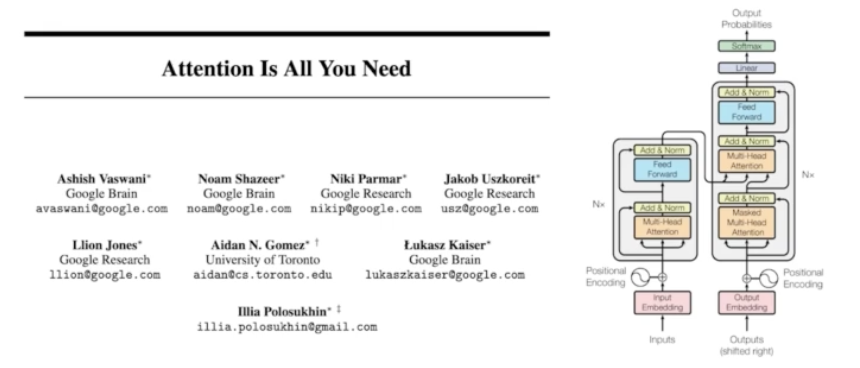

Transformer

Attention이라고도 한다. 현재는 Transformer가 차지하는 비중이 매우 커졌다.

2018

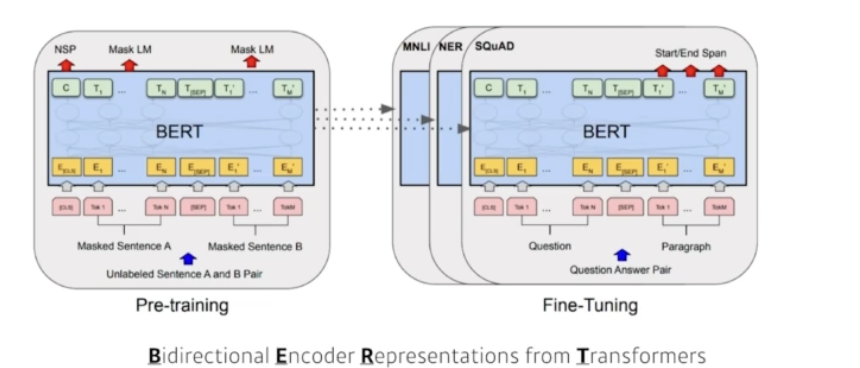

BERT(fine-tuned NLP models)

NLP: 자연어 처리 연산

2019

BIG Language Models

2020

Self Supervised Learning

이미지 분류와 같은 분류 문제를 풀고 싶은데, 학습 데이터가 한정적이고 라벨을 모르는 데이터를 활용할 때

추가로 데이터를 만들어 내서 데이터 량을 증가시키고자 할 때 유리하다.(전문지식이 많은 경우)

© NAVER Connect Foundation. All Rights Reserved

'취업준비 > 인공지능' 카테고리의 다른 글

| [AI Tech] 5주차 21-2차시 Quiz 8 (0) | 2024.02.13 |

|---|---|

| [AI Tech] 5주차 21-1차시 뉴럴 네트워크 - MLP (0) | 2024.02.13 |

| [AI Tech] 5주차 20-1차시 딥러닝 기본 용어 설명 (0) | 2024.02.13 |

| [AI Tech] 4주차 19-2차시 Quiz 7 (0) | 2024.02.06 |

| [AI Tech] 4주차 19-1차시 베이즈 통계학 맛보기 (0) | 2024.02.06 |